近日,由海南大学计算机科学与技术学院副院长、人机物智能数据团队负责人刘华中研究员指导硕士研究生陈鹏旭在国际顶级会议ACM SIGIR Conference on Research and Development in Information Retrieval 2025(简称SIGIR)上发表最新研究论文,题目为“Class Activation Values: Lucid and Faithful Visual Interpretations for CLIP-based Text-Image Retrievals”。SIGIR是中国计算机学会CCF推荐的A类国际学术会议,也是人工智能领域智能信息检索方向最权威的国际会议。该论文的第一作者为计算机科学与技术学院2022级硕士生陈鹏旭,刘华中研究员及多模态数据分析与智能团队负责人丁继红研究员为文章第一、第二通讯作者。

论文提出一种适用于CLIP模型的高清晰、高可信多模态解释方法:类别激活值(Class Activation Values, CAV),有效缓解了图文跨模态检索任务中可解释性不足的问题,包括现有Transformer系列解释方法在图像模态中存在的解释清晰度不足以及文本模态解释不准确或不完整等关键缺陷。

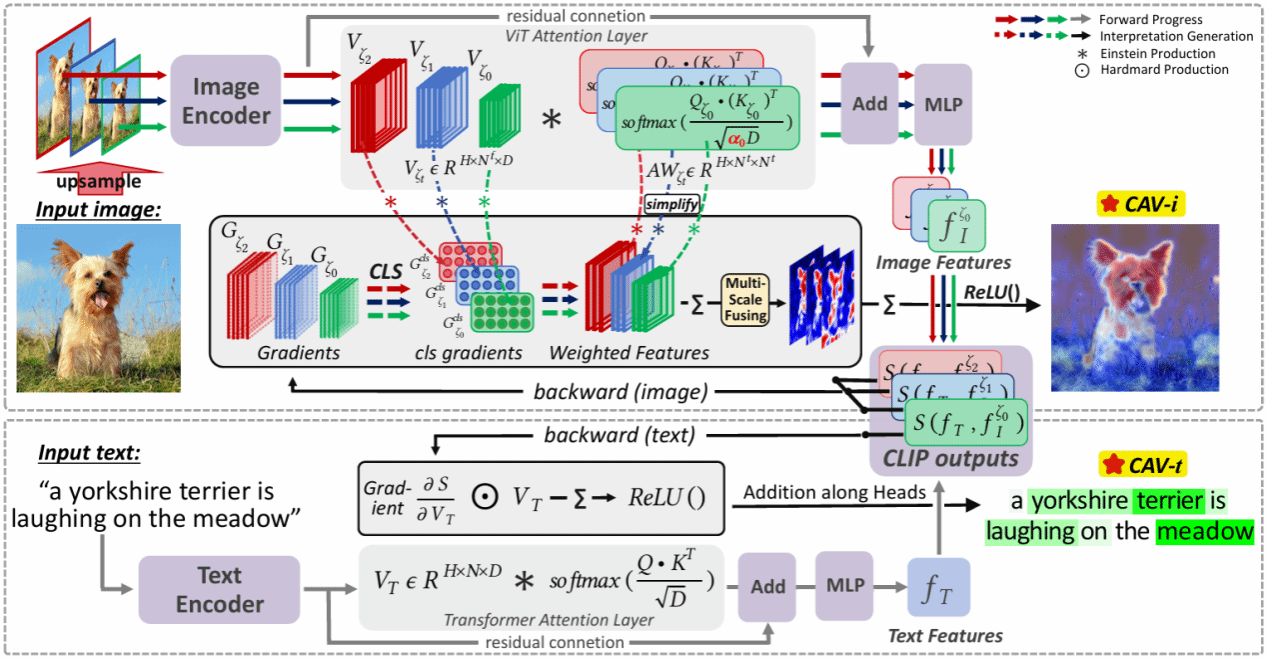

图1 文章框架图

该文章具体有以下两大创新点:

1. 针对CLIP视觉骨干模型(ViT)视觉解释残缺、分辨率低的痛点,文章创新提出ViT多尺度融合归因解释方法(CAV-i),显著提高了图像模态解释清晰度和完整性。

2. 针对CLIP文本骨干模型(Transformer)解释错误、可信度差的痛点,文章深入剖析文本编码器数据流向,并提出一种基于逐元素梯度的Transformer细粒度归因解释方法(CAV-t),可为CLIP图文匹配任务在文本模态提供精准、可信的解释。

实验结果表明,该论文提出的CAV方法在ILSVRC-2012和MS COCO-2014数据集上展现出了最为优异且准确的特征表达能力,能够精准地解释基于CLIP的图文匹配过程。

近年来,刘华中研究员在学术研究、人才培养等方面成果显著,在多模态数据精准分析、可解释性人工智能等领域已主持包括国家重点研发计划项目“基于张量的阿尔茨海默症多模态数据融合与因果推理及可解释辅助诊断”、国家自然科学基金面上项目“教育大数据跨模态融合与多场景高效预测及其可解释性研究”等在内的国家级课题10余项。在CCF A、IEEE/ACM Transactions、中科院一区期刊及国际会议发表学术论文50余篇,并担任IEEE UIC 2024 (CCF C)、IEEE Cybermatics Congress 2023、IEEE GPC 2021、IEEE SmartData 2020/2019程序委员会主席,以及IEEE Metaverse 2022执行主席。该论文的录用也标志着刘华中研究员及其团队在深度学习可解释性领域取得又一里程碑式成果。

海大公众号

海大公众号

学院公众号

学院公众号